-

Andrej Karpathy의 State of GPT 강연 후기코딩/AI, 통계 2023. 6. 3. 22:48반응형

Andrej Karpathy, State of GPT 이 유투브 영상에서는 Tesla의 인공 지능 책임자인 Andrej Karpathy가 GPT와 같은 대규모 언어 모델의 발전과 개발에 대해 공유했습니다. 최근 GPT 트렌드와 응용 방법에 대한 인사이트를 얻을 수 있는 영상이었습니다.

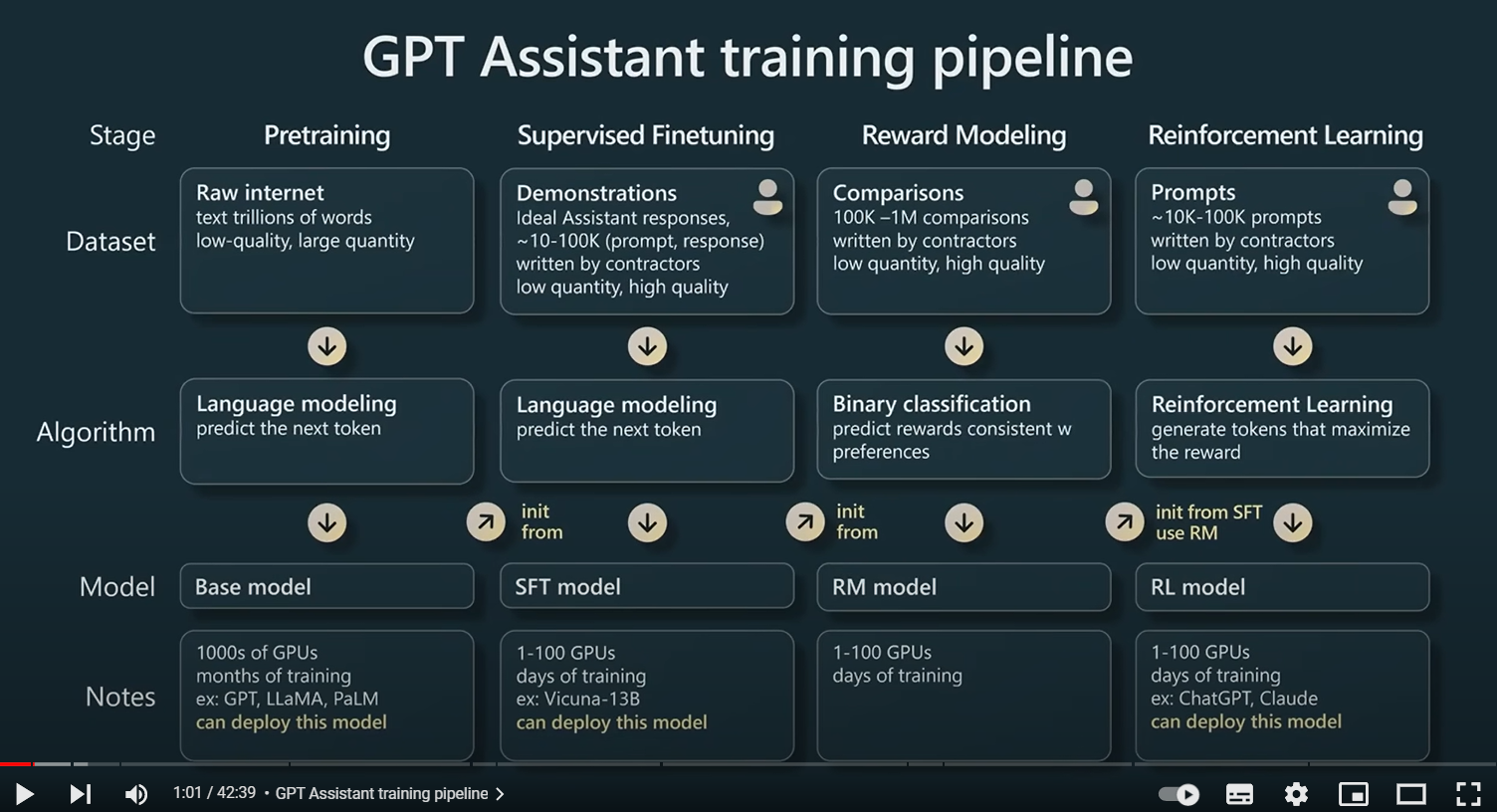

몇 가지 인상 깊었던 내용을 공유하겠습니다.GPT Assistant training pipeling

- 다양한 출처의 데이터로 학습된 Base model은 assitant가 아닙니다. SFT, RM, RL 들의 다양한 방법으로 튜닝되어야 합니다.

- GPT-3와 메타의 최신 모델인 LLaMA를 비교하며, 모델의 성능이 반드시 포함된 매개변수의 수와 상관관계가 있는 것은 아니라고 강조합니다. 예를 들어, LLaMA는 GPT-3보다 파라미터 수가 적지만 광범위한 학습으로 인해 여전히 더 강력한 모델입니다.

- 파인튜닝 과정에서 강화학습 모델이 잘 먹힙니다. 그 이유는 본인도 모른다고 합니다. 아마 새로운 문장을 생성하는 것보다는 생성된 내용에서 좋은 문장을 선택하는 것이 더 쉽기 때문이라고 추정합니다. 강화학습을 활용한 파인튜닝은 아직 학문의 영역임을 언급합니다.

- 하지만 추가로 fine-tuning 된 모델은 예측의 다양성 측면에서 떨어질 수 있습니다. 파인 튜닝으로 모델의 엔트로피가 현저히 떨어질 수 있음을 강조합니다. 만약 다양한 출력 결과를 원하면 기본 모델을 사용하기를 추천합니다.

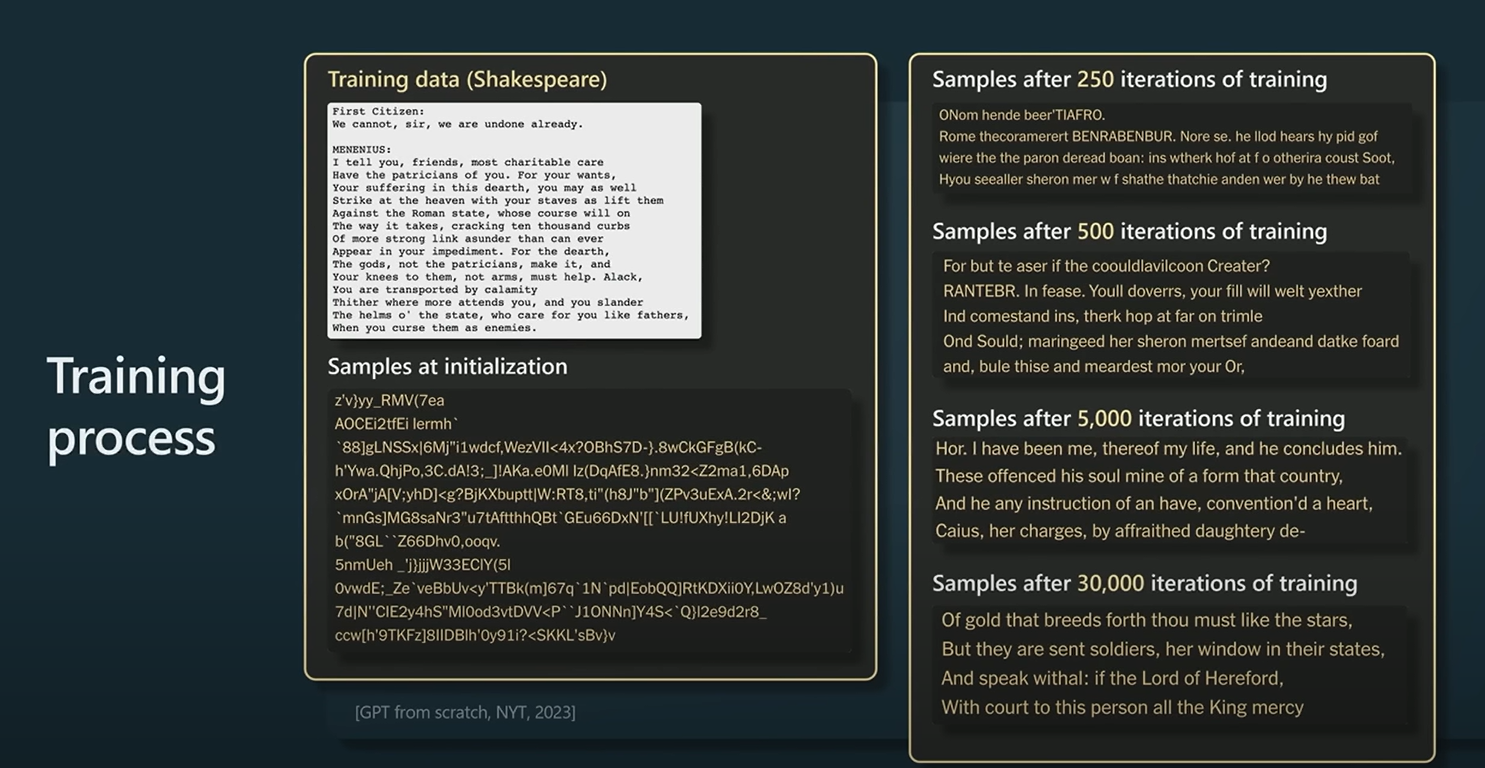

Traning Process

- 뉴욕타임즈에서 실험한 내용을 공유합니다. 반복적인 학습으로 트랜스포머 가중치 업데이트를 통해서, 모델은 시간이 지남에 따라 일관성을 갖게 됩니다. 위 장표와 같이 이터레이션이 반복되면서, 괜찮은 문장을 생성해 내고 있습니다. 상당히 신기하네요...

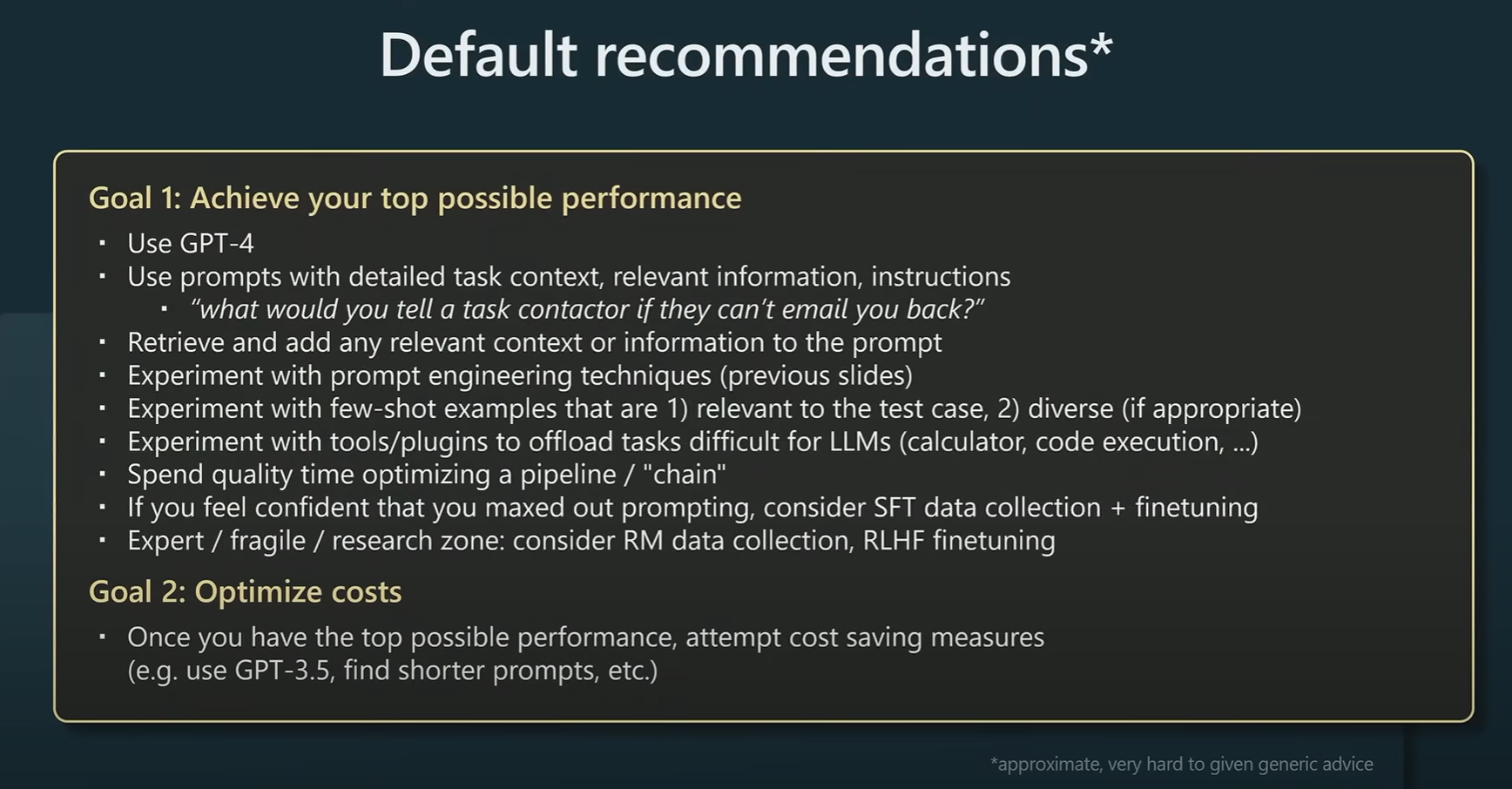

GPT로 무언가를 시도하고자 한다면,

- GPT-4 기반하에,

태스크의 맥락, 관련 정보와 인스트럭션을 이용하여 가장 좋은 결과를 이끌어 내세요. - 이 때, 이 영상에서 소개된 최신 prompt engineering 기법을 실험해 보십시요.

- 프롬프트로 최고의 결과를 이끌어 내었다면, SFT 기법을 이용한 파인튜닝을 고려해 보십시요

- RLHF는 아직 연구 중인 분야입니다.

- 만약 위 방법론으로, 최고의 결과를 도출했다면 비용 절감을 위한 방법을 고민해 보세요

(GPT 3.5를 사용하는 것도 하나의 방법입니다.)

반응형'코딩 > AI, 통계' 카테고리의 다른 글

최고의 번역툴, Deepl 서비스 이용 방법 및 국내 출시 일정 (0) 2023.08.18 ChatGPT 대체할 AI 플랫폼 Top 5 (0) 2023.07.25 생산성 향상을 위한 chatGPT 업무용 프롬프트 Best 5 (0) 2023.07.24 OpenAI 달리2(Dall-E2) 사용하여, 간단히 블로그 이미지 만들기. (2) 2023.06.07 Chat GPT로 미국 스타트업 재무재표 분석해보기 (0) 2023.06.04